Original Article - Year 2020 - Volume 35 -

Avaliação de três sistemas de classificação das fraturas da extremidade distal do rádio: Frykman, Universal and A.O.

Evaluation of three classification systems for fractures of the distal end of the radius: Frykman, Universal and A.O.

RESUMO

Introdução: As fraturas da extremidade distal do rádio estão entre as mais incidentes de todas as fraturas do corpo. As classificações das fraturas são amplamente utilizadas para definição de tratamento e prognóstico.

Métodos: Foram selecionadas radiografias de 14 pacientes com fratura da extremidade distal do rádio nas incidências anteroposterior e perfil, e um caso foi propositalmente repetido. Todas as imagens foram avaliadas por 12 participantes em diferentes estágios de formação profissional (4 residentes e 8 ortopedistas), em dois momentos distintos, com intervalo de 1 semana. Analisou-se a concordância inter e intraobservadores por meio do coeficiente Kappa ponderado. O testet de Student para amostras pareadas foi aplicado para verificar se havia diferença significativa no grau de concordância interobservador entre os instrumentos.

Resultados: A classificação Universal apresentou grande reprodutibilidade intraobservadores (k = 0.72) e moderada interobservador (k = 0.48). Frykman teve reprodutibilidade moderada e leve intra e interobservador, respectivamente (k = 0.51 e 0.36). A classificação do grupo A.O. demonstrou reprodutibilidade leve intraobservadores e interobservador (k = 0.38 e 0.25, respectivamente).

Conclusão: A maior concordância intra e interobservador foi observada na classificação Universal, seguida pela de Frykman e, por último, a do grupo A.O. A reprodutibilidade da classificação não variou significativamente com o grau de experiência do avaliador.

Palavras-chave: Fratura de Colles; Fraturas do rádio; Classificação; Reprodutibilidade dos testes; Diagnóstico

ABSTRACT

Introduction: Fractures at the distal end of the radius are among the most frequent fractures. Fracture classifications are widely used to define treatment and prognosis.

Methods: radiographs were selected from 14 patients with fractures of the distal end of the radius in anteroposterior and profile views, and one case was repeated on purpose. Twelve participants at different stages of professional training (four residents and eight orthopedists) evaluated all the images at two different times, with an interval of 1 week. The inter and intraobserver concordance was analyzed using the weighted Kappa coefficient. The Student's t-test for paired samples was applied to verify if there was a significant difference in the degree of inter-observer concordance between the instruments.

Results: Universal classification showed great intra-observer reproducibility (k = 0.72) and moderate interobserver reproducibility (k = 0.48). Frykman had moderate and mild intra and interobserver reproducibility, respectively (k = 0.51 and 0.36). The classification of the group A.O. demonstrated mild intraobserver and interobserver reproducibility (k = 0.38 and 0.25, respectively).

Conclusion: The highest intra and interobserver concordance was observed in the Universal classification, followed by Frykman and, finally, that of the group A.O. The reproducibility of the classification did not vary significantly with the degree of experience of the evaluator.

Keywords: Colles Fracture; Radius Fractures; Classification; Reproducibility of tests; Diagnosis.

INTRODUÇÃO

As fraturas da extremidade distal do rádio são definidas como aquelas que ocorrem até três centímetros da articulação radiocárpica1. Possuem uma incidência de aproximadamente 1:10000 pessoas, representando 16% de todas as fraturas do corpo humano2. A faixa etária mais acometida é entre 60 e 69 anos, principalmente em mulheres, mas nota-se uma elevação da incidência entre jovens devido aos acidentes de trânsito e traumas esportivos, de alta energia1-3. A incidência elevada em idosos se correlaciona à osteoporose, sexo feminino, raça branca e menopausa precoce1-3.

O diagnóstico das fraturas do rádio é baseado na história clínica, no exame físico e na avaliação por imagem, normalmente obtido com radiografias simples do punho na incidência anteroposterior (AP) e em perfil1-3. As fraturas da extremidade distal do rádio são divididas de acordo com o padrão da lesão. Assim, as classificações são importantes na medida em que auxiliam na tomada de decisão do tratamento a ser instituído e orientam o prognóstico das fraturas4.

A classificação de Frykman foi, por muitos anos, o sistema mais utilizado, e se baseia no envolvimento das superfícies articulares do rádio, podendo ser classificada de 1 a 85. A classificação Universal ou de Rayhack foi criada em 1990 e modificada por Cooney, em 19936. Diferencia as fraturas em intra ou extra-articulares, com ou sem desvios, sua redutibilidade e estabilidade6. A classificação do Grupo A.O./OTA foi criada em 1986 e revisada em 1990. Divide-se em extra-articular (tipo A), articular parcial (tipo B) e articular completa (tipo C). Os três grupos são organizados em ordem crescente de gravidade com relação à complexidade morfológica, dificuldade de tratamento e prognóstico7.

Os estudos atualmente encontrados na literatura apresentam metodologias muito distintas e mostram baixa reprodutibilidade intra e interobservador nas diferentes classificações das fraturas da extremidade distal do rádio, não havendo um consenso de qual sistema deve ser utilizado na prática diária e na realização de estudos científicos4,8-10.

OBJETIVO

O objetivo deste trabalho é avaliar a reprodutibilidade das três principais classificações e definir qual delas tem maior concordância intra e interobservador, e se o estágio de formação dos participantes influencia na avaliação.

MÉTODOS

Trata-se de um estudo observacional, incluindo exames de imagem de 14 pacientes atendidos no pronto socorro de um hospital da rede pública de saúde, com diagnóstico de fratura da extremidade distal do rádio, no período de junho a setembro de 2017. Todos os pacientes incluídos possuíam radiografias em duas incidências, anteroposterior e em perfil. Foram excluídos os pacientes com esqueleto imaturo, aqueles que não possuírem radiografia de qualidade satisfatória, e aqueles com fraturas ou deformidades prévias no punho. Para a avaliação foram apresentados aos avaliadores 15 casos, pois propositalmente um paciente se repetia, com o intuito de melhorar a acurácia intraobservadores.

Selecionados como participantes 12 ortopedistas em diferentes estágios de formação, sendo oito membros da Sociedade Brasileira de Ortopedia e Traumatologia, dois especialistas em cirurgia da mão e seis não especialistas; e, quatro médicos residentes, um no primeiro ano de formação (R1), dois no segundo ano (R2) e um no terceiro ano (R3). Os avaliadores classificaram as fraturas apresentadas após uma breve explanação sobre os sistemas de classificação e foi permitida a consulta deles a qualquer momento da avaliação. Após sete dias os participantes classificaram novamente as mesmas fraturas.

O estudo atendeu todos os requisitos em relação aos direitos dos seres humanos e foi aprovado pelo Comitê de Ética em Pesquisa da instituição (parecer consubstanciado n° 2.294.348).

Análise estatística

A análise inferencial foi composta pelo coeficiente de Kappa ponderado para análise de concordância intra e interobservador das classificações de Frykman, Universal e AO. O teste t de Student para amostra pareadas foi aplicado para verificar se existia diferença significativa no grau de concordância interobservador entre os instrumentos. A interpretação dos valores Kappa foi feito de acordo com o proposto por Landis e Koch, em 197711, segundo os quais, valores Kappa menores que zero representam uma má reprodutibilidade, de zero a 0,20 desprezível, 0,21 a 0,40 reprodutibilidade leve, 0,41 a 0,60 reprodutibilidade moderada, 0,61 a 0,80 reprodutibilidade grande e acima de 0,80 considera-se uma concordância quase perfeita. Os valores obtidos da estatística Kappa foram testados em nível de significância de 5%.

RESULTADOS

Dentre as classificações observou-se melhor reprodutibilidade na classificação Universal, tendo com índice Kappa de 0.72 considerado como grande reprodutibilidade intraobservadores. Já na avaliação interobservador esse índice apresentou uma ligeira queda, deixando de ter uma grande reprodutibilidade, passando para moderado com valor de 0.48. A classificação de Frykman apresentou um índice Kappa de 0.51, sendo considerado moderada a reprodutibilidade quanto às avaliações intraobservadores. Na avaliação interobservador o índice foi de 0.36, classificado como leve. A classificação do grupo A.O. apresentou reprodutibilidade leve intraobservadores e interobservador (κ = 0.38 e 0.25, respectivamente) (Tabelas 1 e 2).

| Momento 1 | Momento 3 | |||

|---|---|---|---|---|

| Sistema | Kappa | Concordância | Kappa | Concordância |

| Frykman | 0,36 | Leve | 0,41 | Moderada |

| Universal | 0,48 | Moderada | 0,47 | Moderada |

| A.O. | 0,25 | Leve | 0,29 | Leve |

| Sistema | Kappa | Concordância |

|---|---|---|

| Frykman | 0,51 | Moderada |

| Universal | 0,72 | Grande |

| A.O. | 0,38 | Leve |

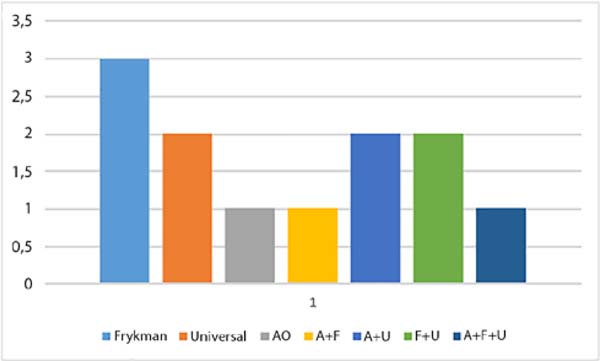

Ao analisar a classificação da fratura que se repetia, notou-se que apenas um avaliador questionou ser a mesma radiografia já avaliada anteriormente, porém todos os avaliadores classificaram a lesão da mesma forma em pelo menos um dos três sistemas. A classificação de Frykman apresentou reprodutibilidade igual à classificação Universal, com sete acertos, enquanto a do grupo A.O. apresentou cinco acertos (Figura 1).

Ao se analisar o grau de formação e experiência do avaliador, não se obteve variação estatisticamente significativa em relação aos valores do índice Kappa (p < 0.05).

DISCUSSÃO

A classificação ideal de qualquer fratura deve fornecer informações suficientes para auxiliar na tomada de decisão do tratamento adequado, determinar o prognóstico, além de ter uma reprodutibilidade satisfatória e ser de fácil memorização12. A reprodutibilidade do sistema é conferida pelas concordâncias inter e intraobservadores, sendo essencial uma classificação ter uma boa reprodutibilidade para que possa ser largamente aceita e permitir que diferentes séries sejam comparadas4,8. No presente estudo, analisamos a reprodutibilidade das fraturas da extremidade distal do rádio e observou-se maior concordância inter e intraobservadores na classificação Universal, seguida pela de Frykman e, por último, a da A.O. Nos diversos trabalhos encontrados na literatura, assim como neste, a maioria utilizava o índice Kappa inter e intraobservadores para avaliar a concordância dos diferentes tipos de classificações das fraturas4,8,10.

Andersen et al., em 199613, estudaram quatro classificações para as fraturas distais do rádio: Frykman, Melone, Mayo e A.O. Verificaram que nenhuma delas mostrou grande concordância interobservador (Kappa entre 0.61 e 0.80). Na classificação de Frykman, a concordância intraobservadores variou de 0.40 a 0.60 e a interobservador teve o índice Kappa médio de 0.36. Com relação ao sistema A.O. completo, a concordância média intraobservadores variou de 0.22 a 0.37 e, quando reduzida para três categorias, obteve-se um nível de concordância de 0.58 a 0.70. Contudo, reduzindo para três categorias, o sistema A.O. passa a ter valor questionável frente às outras classificações.

Avaliando a reprodutibilidade do sistema A.O. em 30 radiografias de fraturas distais do rádio, classificadas por 36 observadores com diferentes níveis de experiência, Kreder et al., em 199614, mostraram que a concordância interobservadores foi melhor para a classificação simplificada (κ = 0.68) e decresceu progressivamente ao incluir os grupos (κ = 0.48) e subgrupos (κ = 0.33) deste sistema. O índice Kappa variou de 0.25 a 0.42 na concordância intraobservadores com o sistema A.O. completo e de 0.40 a 0.86 na classificação simplificada. Não houve diferença em relação ao grau de experiência dos observadores ao classificarem os “grupos” e “subgrupos”.

Illarramendi et al., em 199815, utilizaram 200 radiografias classificadas por seis observadores com níveis diferentes de experiência. Para a classificação de Frykman, obtiveram reprodutibilidade interobservador moderada (κ = 0.43) e intraobservadores boa (κ = 0.61). Para a classificação A.O., encontraram uma leve reprodutibilidade interobservador (κ = 0.37) e moderada intraobservadores (κ = 0.57). Para a obtenção de tais resultados, entretanto, os autores simplificaram as classificações de Frykman e A.O., melhorando a reprodutibilidade de ambas, o que talvez não ocorreria se estivessem completas. Houve maior reprodutibilidade intraobservador que interobservador e a concordância não melhorou com o aumento da experiência do observador.

Ainda não há um consenso sobre a metodologia ideal nos estudos de reprodutibilidade de classificações, uma vez que o número de exames de imagens analisados e a quantidade de avaliadores influenciam na concordância das respostas13-15. No estudo de Kreder et al., em 199614, foram 30 imagens e 36 avaliadores, enquanto no apresentado por Illarramendi et al., em 199815, seis participantes julgaram 200 imagens.

No presente estudo, optamos por diminuir o número de fraturas, totalizando 15 com duas incidências cada, para não tornar o processo cansativo, o que poderia prejudicar o resultado das avaliações. Entretanto, concordando com os estudos prévio, do ponto de vista da reprodutibilidade, constatamos que as classificações avaliadas não foram satisfatórias, com resultado considerado bom somente para a concordância intraobservadores na Universal, no restante, a concordância foi leve à moderada13-15. Outro ponto de consentimento com os estudos citados é a pouca influência do nível de experiência dos participantes ao classificarem as fraturas distais do rádio, uma vez que não houve diferença significativa entre residentes e especialistas13,15.

Além disso, diferentemente de pesquisas prévias, propositalmente repetimos um caso para melhor avaliação concordância intraobservadores. Observou-se que muitos avaliadores não conseguiram identificar que estavam classificando radiografias repetidas, ratificando a dificuldade em se criar um sistema de classificação altamente reprodutível.

CONCLUSÃO

A maior concordância intra e interobservador foi observada na classificação Universal, seguida pela de Frykman e, por último, a do grupo A.O.; entretanto, constatamos que a reprodutibilidade das classificações não foi satisfatória, com resultado considerado bom somente para a concordância intraobservadores na Universal. Além disso, notou-se que a reprodutibilidade da classificação independe do grau de experiência do avaliador.

COLABAORAÇÕES

|

HM |

Análise e/ou interpretação dos dados, aprovação final do manuscrito, concepção e desenho do estudo, gerenciamento do projeto, redação - preparação do original, redação - revisão e edição, supervisão. |

|

LDG |

Análise e/ou interpretação dos dados, análise estatística, coleta de dados, metodologia, realização das operações e/ou experimentos, redação - preparação do original. |

REFERÊNCIAS

1. Mallmin H, Ljunghall S. Incidente of Colles' fracture in Uppsala. A prospective study of a quarter-million population. Acta Orthop Scand. 1992 Apr;63(2):213-5.

2. Pires PR. Fraturas do rádio distal. In: Traumatologia Ortopédica. Rio de Janeiro: Revinter; 2004.

3. Bucholz RW, Heckman JD, Court-Brown CM, Tornetta P. Rockwood and Green's Fractures in Adults. 7th ed. Philadelphia: Lippincott Williams & Wilkins; 2009.

4. Belloti JC, Tamaoki MJS, Santos JBG, Balbachevsky D, Chap EC, Albertoni WM, et al. As classificações das fraturas do rádio distal são reprodutíveis? Concordância intra e interobservadores. São Paulo Med J. 2008;126(3):180-5.

5. Frykman G. Fracture of the distal radius, including sequilla of shoulder-hand síndrome: disturbance of the distal radio-ulnar joint and impairment of nerve function. A clinical and experimental study. Acta Orthop Scand Suppl. 1973;108:1.

6. Cooney WP. Fractures of the distal radius: a modern treatment-based classification. Orthop Clin North Am. 1993 Apr;24(2):211-6.

7. Hahn DM, Colton CL. Distal radius fractures. In: Rüedi TP, Murphy WM, eds. AO Principles of fracture management. New York: Medical Publishers; 2001. p. 357-77.

8. Oskam J, Kingma J, Klasen HJ. Interrater reliability for the basic categories of the AO/ASIF system as a frame of referece for classifying distal radial fractures. Percept Mot Skills. 2001 Apr;92(2):589-94.

9. Reis FB, Faloppa F, Saone RP, Boni JR, Corvelo MC. Fraturas do terço distal do rádio: classificação e tratamento. Rev Bras Ortop. 1994;29(5):326-30.

10. Oliveira Filho OM, Belangero WD, Teles JBM. Fraturas do rádio distal: avaliação das classificações. Rev Assoc Med Bras. 2004;50(1):55-61.

11. Landis JR, Koch GG. The measurement of observer agreement for categorical data. Biometrics. 1977 Mar;33(1):159-74.

12. Belloti JC, Santos JBG, Erazo JP Iani LJ, Tamaoki MJS, Moraes VY, et al. Um novo método de classificação para as fraturas da extremidade distal do rádio - a classificação IDEAL. Rev Bras Ortop. 2013;48(1):36-40.

13. Andersen DJ, Blair WF, Steyers Junior CM, Adams BD, El-Khouri GY, Brandser EA. Classification of distal radius fractures: an analysis of interobserver reliability and intraobserver reproducibility. J Hand Surg Am. 1996 Jul;21(4):574-82.

14. Kreder HJ, Hanel DP, McKee M, Jupiter J, McGillivary G, Swiontkowski MF. Consistency of AO fracture classification for the distal radius. J Bone Joint Surg Br. 1996 Sep;78(5):726-31.

15. Illarramendi A, Della Valle AG, Segal E, Carli P, Maignon G, Gallucci G. Evaluation of simplified Frykman and AO classifications of fractures of the distal radius Assessment of interobserver and intraobserver agreement. Int Orthop. 1998;22(2):111-5.

1. Hospital Sírio-Libanês, Brasília, DF, Brasil.

2. Universidade de Brasília, Brasília, DF, Brasil.

3. Hospital Regional do Paranoá, Brasília, DF, Brasil.

Autor correspondente: Henrique Mansur, Área Militar do Aeroporto Internacional de Brasília, Lago Sul, Brasília, DF, Brasil. CEP: 71607-900. E-mail: henrimansur@globo.com

Artigo submetido: 20/09/2019.

Artigo aceito: 22/02/2020.

Conflitos de interesse: não há.

Read in Portuguese

Read in Portuguese

Read in English

Read in English

PDF PT

PDF PT

Print

Print

Send this article by email

Send this article by email

How to Cite

How to Cite

Mendeley

Mendeley

Pocket

Pocket

Twitter

Twitter